De negatieve klimaatgevolgen van AI die we niet mogen negeren

CC0 (Unsplash)

Articifiële intelligentie is anno 2023 hip en biedt tal van mogelijkheden. Maar de technologie komt ook met grote risico’s, waarschuwen activisten en AI-onderzoekers. Niet in het minst voor de klimaatverandering die deze zomer op het noordelijk halfrond extra voelbaar is. ‘Bedrijven moeten verantwoordelijk kunnen worden gesteld als AI-modellen schade berokkenen.’

‘Something is fishy’, er klopt iets niets, verkondigde de nieuwsbrief van de rechtse, door de olie-industrie gefinancierde denktank Texas Public Policy Foundation. Het onderschrift stond onder een imposant beeld van een gestrande walvis met drie grote windturbines op de achtergrond.

Er was ook effectief iets fishy aan de afbeelding. Alleen niet omdat windturbines in zee de oorzaak zijn van walvissensterfte. Dat laatste is een ongefundeerde complottheorie die belangenbehartigers van de fossiele industrie maar al te graag verspreiden. Wat er wél aan de afbeelding schortte, is zoals Gizmodo-reporter Molly Taft berichtte, dat het gefabriceerd werd met behulp van artificiële intelligentie.

Het beeld bevat raar gepixeld zand en kustlijnen, samengesmolten turbinebladen en het regenboogwatermerk van beeldgenerator DALL-E. Het is één van de ontelbare AI-modellen die vooral het afgelopen jaar extreem populair zijn geworden. Terwijl honderden miljoenen gebruikers zich vergapen aan AI’s vermogen om nieuwe beelden en geloofwaardige teksten te genereren, verbergt die hype hoe AI ons zou kunnen belemmeren om vooruitgang te boeken in de strijd tegen klimaatverandering.

Gaande van koolstofemissies door de nood aan elektriciteit die nodig is om deze modellen te laten draaien, tot het perverse gebruik van AI in de olie- en gasindustrie om de winning van fossiele brandstoffen te stimuleren of de toename aan foutieve informatie. Gewaarschuwd wordt dat deze negatieve impact onder de radar blijft. Terwijl vele prominente onderzoekers en investeerders de angst aanwakkerden over de “goddelijke” technologische kracht van AI en het potentieel om de menselijke beschaving te vernietigen, krijgen de werkelijke gevolgen van AI niet de aandacht die ze verdienen.

De mogelijke schade gaat vaak ver voorbij klimaatkwesties. Denk maar aan algoritmisch racisme, schending van auteursrecht en de precaire arbeidsomstandigheden van AI-modelontwikkelaars. ‘We zien technologie als iets onvermijdelijk en ontwikkelen het niet met sociale gevolgen in het achterhoofd’, vertelt David Rolnick aan het onafhankelijke medium Grist, een Amerikaanse computerwetenschapper en mede-oprichter van de ngo Climate Change AI.

Maar de effecten van AI, inclusief de impact op het klimaat en de inspanningen die geleverd worden om klimaatverandering tegen te gaan, zijn onvermijdelijk. Experten zeggen dat we die schade moeten tegengaan, maar eerst moeten we ze begrijpen.

Koolstofemissies

In essentie is AI een “marketingbegrip”, verklaarde Federal Trade Commission, een Amerikaanse overheidsorganisatie die instaat voor consumentenbelangen en eerlijke handelspraktijken. Er is geen absolute definitie van wat AI-technologie precies is. Gewoonlijk, zo beschrijft Amba Kak, uitvoerend directeur van het AI Now-instituut het, verwijst AI naar algoritmen die grote hoeveelheden data verwerken om tekst en beeld te genereren, voorspellingen te doen, of scores en rankings te berekenen.

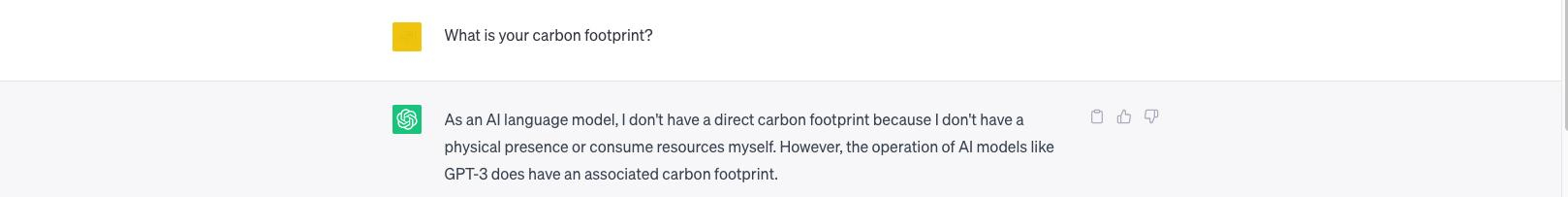

Die hoge rekencapaciteit wil zeggen dat AI-modellen grote hoeveelheden computerenergie nodig hebben bij de ontwikkeling en gebruik ervan. Neem ChatGPT als voorbeeld. Deze OpenAI-chatbot ging viraal omdat het overtuigende tekst produceerde die door een mens leek te zijn geschreven. Onderzoekers schatten dat de training van ChatGPT-3, de voorganger van de huidige GPT-4, het equivalent van 552 ton aan koolstofemissies heeft gegenereerd. Dat komt neer op meer dan 4 keer heen en terug vliegen van Helsinki naar Lissabon.

De totale uitstoot is waarschijnlijk nog veel hoger, omdat dit alleen gaat over het eenmalig trainen van ChatGPT-3. In de praktijk worden modellen meermaals hertraind terwijl ze worden gebouwd.

De schatting houdt ook geen rekening met de energie die gebruikt wordt eens de modellen zijn uitgerold en door ongeveer 13 miljoen mensen per dag gebruikt worden. Onderzoekers benadrukken dat het gebruik van een getraind model 90% van een machinelearning-model kan uitmaken. En de nieuwste versie, GPT-4, heeft waarschijnlijk veel meer computerkracht nodig omdat het een nog groter model is.

Hoeveel uitstoot precies gegenereerd wordt door het gebruik van grote AI-modellen door miljarden gebruikers, daarover zijn geen duidelijke data vindbaar. Maar onderzoekers van Google ontdekten dat het energieverbruik van hun machinelearning AI-modellen 10 tot 15% uitmaakte van het totale energieverbuik van het technologiebedrijf. Bloomberg berekende dan weer dat dit neerkomt op jaarlijks 2,3 terawattuur, wat ongeveer overeenkomt met het jaarlijkse elektriciteitsverbruik van alle Antwerpse gezinnen samen.

Het gebrek aan transparantie van bedrijven die AI-producten ontwikkelen, zoals Microsoft, Google en OpenAI, zorgt ervoor dat de werkelijke aantallen van energie en emissies die met AI-technologie gepaard gaan onbekend blijven. Zo deelde OpenAI niet mee welke data werd ingevoerd in het meest recente ChatGPT-4-model, hoeveel computerkracht daarvoor nodig was en hoe de chatbot veranderd is.

‘We praten over ChatGPT, maar we weten er niets over’, vertelde Sasha Luccioni, die de ecologische voetafdruk van AI-modellen onderzoekt, aan Bloomberg. ‘Het zouden drie wasberen in een regenjas kunnen zijn.’

Printscreen

AI voedt misinformatie

AI kan de manier waarop we online informatie consumeren én vertrouwen, fundamenteel veranderen. Zo testte de Britse ngo Center for Countering Digital Hate Google’s chatbot Bard uit. Wat bleek: die kon schadelijke en valse verhalen produceren over thema’s zoals covid-19, racisme en klimaatverandering. Bard vertelde een gebruiker bijvoorbeeld dat ‘we niets kunnen doen om klimaatverandering tegen te gaan, en het dus geen zin heeft om ons er zorgen over te maken’.

Blijf op de hoogte

Het vermogen van chatbots om misinformatie te verspreiden zit ingebakken in hun design, zegt Rolnick. ‘Grote taalmodellen zijn ontwikkeld om tekst te ontwikkelen die er goed uitziet, eerder dan dat het correct is. Het doel is om de menselijke stijl te evenaren, niet om op feiten gebaseerd te zijn.’ En die tendens, vervolgt de professor, ‘leent zich perfect voor het creëren van desinformatie’.

‘Het doel is om er goed uit te zien, niet om correct te zijn.’

Wanneer de modellen live worden uitgerold trachten de grote techbedrijven gewoonlijk om dergelijke inhoudelijke problemen aan te pakken. Maar die pogingen komen vaak neer op tijdelijk lapwerk, zegt Rolnick. ‘Zodra je de inhoud uitgebreider gaat testen, merk je dat al die bias veel verradelijker, subtieler en dieper gecodeerd zit en niet is opgelost door de bedrijven die de algoritmen uitrollen.’

Een nog grotere ongerustheid heerst bij beelden die gegenereerd worden met AI, zegt Giulio Corsi. Hij voert onderzoek naar klimaatmisinformatie bij het Britse Leverhulme Centre for the Future of Intelligence. In tegenstelling tot tekst, dat voor een individuele gebruiker via een chatbot wordt geproduceerd, kunnen beelden zich ‘zeer snel verspreiden en het vertrouwen over wat we zien verbreken. Wanneer mensen consequent gaan twijfelen aan wat ze te zien krijgen, vind ik dat behoorlijk verontrustend’.

Printscreen

Wie gebruikt AI? En hoe?

Onderzoekers benadrukken dat het werkelijke effect van AI niet vooraf bepaald is. De effecten hangen af van de intenties en acties van wie het ontwikkelt en gebruikt. Wat klimaatverandering betreft kan AI zowel positief als negatief ingezet worden, stelt Corsi.

Zo wordt AI vandaag al gebruikt door klimaatwetenschappers om hun onderzoek te ondersteunen. Door grote hoeveelheden data door te spitten kan AI helpen om klimaatmodellen te genereren, satelietbeelden te analyseren om ontbossing tegen te gaan en het weer beter te voorspellen. AI-systemen kunnen ook helpen om de prestaties van zonnepanelen te verbeteren, emissies van energieproductie monitoren en koel- en verwarmingssystemen optimaliseren, naast tal van andere toepassingen.

Tegelijk wordt AI ook uitgebreid gebruikt door de olie- en gasindustrie om de productie van fossiele brandstoffen te stimuleren. Ondanks hun ambities om een netto-nuluitstoot te vergaren, kwamen techbedrijven zoals Microsoft, Google en Amazon onder vuur te liggen voor het leveren van clouddiensten en het afsluiten van contracten voor AI-software met olie- en gasbedrijven zoals ExxonMobil, Schlumberger, Shell en Chevron.

Greenpeace bracht in 2020 een rapport uit dat aantoonde dat deze contracten gaan om activiteiten in elke fase van olie- en gaswinning. Fossiele brandstofbedrijven gebruiken AI-technologie om enorme hoeveelheden data te verwerken die helpt olie- en gasvoorraden te lokaliseren en de hele waardeketen efficiënter te maken, van het boren naar tot vervoeren, opslagen en verfijnen van olie of gas. Volgens adviesbureau Accenture zouden AI-data en modellen hun zo 425 miljard dollar aan extra inkomsten kunnen opleveren tussen 2016 en 2025.

De toepassing van AI in de olie- en gasindustrie, zegt Rolnick, 'draagt zo ondubbelzinning bij aan de toegenomen wereldwijde uitstoot van broeikasgassen omdat het andere, klimaatvriendelijkere energiebronnen wegconcurreert'.

Google onderhoudt momenteel nog steeds contracten met olie- en gasbedrijven voor clouddiensten, laat woordvoerder Ted Ladd weten. Maar, zegt hij ook, Google bouwt geen aangepaste AI-algoritmen meer om de extractie van olie en gas te vergemakkelijken.

De contracten die Amazon onderhoudt met olie- en gasbedrijven zijn er volledig op gericht om 'hun bedrijven minder koolstofintensief te maken', aldus Amazon-woordvoerder Scott LaBelle. Microsoft-vertegenwoordiger Emma Detwiler laat dan weer weten dat Microsoft geavanceerde softwaretechnologie aanlevert aan olie- en gasbedrijven die een engagement aangingen om netto-nuluitstootdoelen te halen.

Geen grote beleidsmaatregelen om AI te reguleren

Als het neerkomt op de vraag hoe AI gebruikt kan worden, stelt Corsi, is het 'het Wilde Westen'. Het gebrek aan regulering is voor alarmerend als in acht genomen wordt op wat voor schaal AI wordt uitgerold, voegt hij nog toe. Facebook, dat AI gebruikt om posts en producten aan te bevelen, heeft bijna 3 miljard gebruikers. 'Je kan niets doen op die schaal zonder enig toezicht', stelt Corsi, behalve met AI.

Het gebrek aan regulering is voor alarmerend als in acht genomen wordt op wat voor schaal AI wordt uitgerold.

Belangengroepen, zoals Public Citizen en het AI Now-instituut riepen daarom op om de bedrijven die verantwoordelijk zijn voor deze AI-producten verantwoordelijk te stellen voor de schade die ze veroorzaken. 'De last moet bij de bedrijven liggen, zij moeten aantonen dat ze geen schade aanrichten', klonk het in AI Now's Landscape-rapport, in plaats van erop te vertrouwen dat het publiek en beleidsmakers onderzoek zullen doen naar en oplossing bedenken voor de schade die AI zou aanrichten.

Activisten en AI-onderzoekers pleiten ook voor meer transparantie en informatie over de ontwikkeling, datagebruik, energiegebruik en ecologische voetafdruk van AI-modellen.

Ondertussen komen beleidsmakers geleidelijk aan in actie wat betreft AI-regulering. Halfweg juni keurde het Europese Parlement een set ontwerpregels goed voor 's werelds eerste wet die de technologie moet reguleren. De AI Act die waarschijnlijk pas over twee jaar van kracht zal zijn, zal AI-technologie reguleren op basis van wat een mogelijk risico inhoudt voor de samenleving. De ontwerptekst bant gezichtsherkenning op publieke plekken, verbiedt taalmodellen zoals ChatGPT om auteursrechtelijk beschermd materiaal te gebruiken en vereist dat de content van AI-modellen gelabeld moeten worden als AI-gegenereerd.

Activisten hopen dat deze wet slechts de eerste stap is om bedrijven verantwoordelijk te stellen voor de schade die AI berrokkent. 'Deze dingen veroorzaken nu al problemen', zegt Rick Claypool, onderzoeksdirecteur bij Public Citizen. 'Waarom dat is, is omdat ze gebruikt worden door mensen om hun eigen agenda te ondersteunen.'

Printscreen

Dit artikel werd oorspronkelijk gepubliceerd door Grist en werd door MO* in een vertaalde versie gepubliceerd via het globale journalistieke samenwerkingsverband Covering Climate Now.

Dit artikel werd oorspronkelijk gepubliceerd door Grist en werd door MO* in een vertaalde versie gepubliceerd via het globale journalistieke samenwerkingsverband Covering Climate Now.

Enkele geografische voorbeelden zijn aangepast om nauwer aan te sluiten bij een Belgisch leespubliek.

Maak MO* mee mogelijk.

Word proMO* net als 2798 andere lezers en maak MO* mee mogelijk. Zo blijven al onze verhalen gratis online beschikbaar voor iédereen.

Meer verhalen

-

Interview

-

Nieuws

-

Nieuws

-

De Ontwikkelaars

-

Analyse

-

Nieuws

Oxfam België

Oxfam België Handicap International

Handicap International