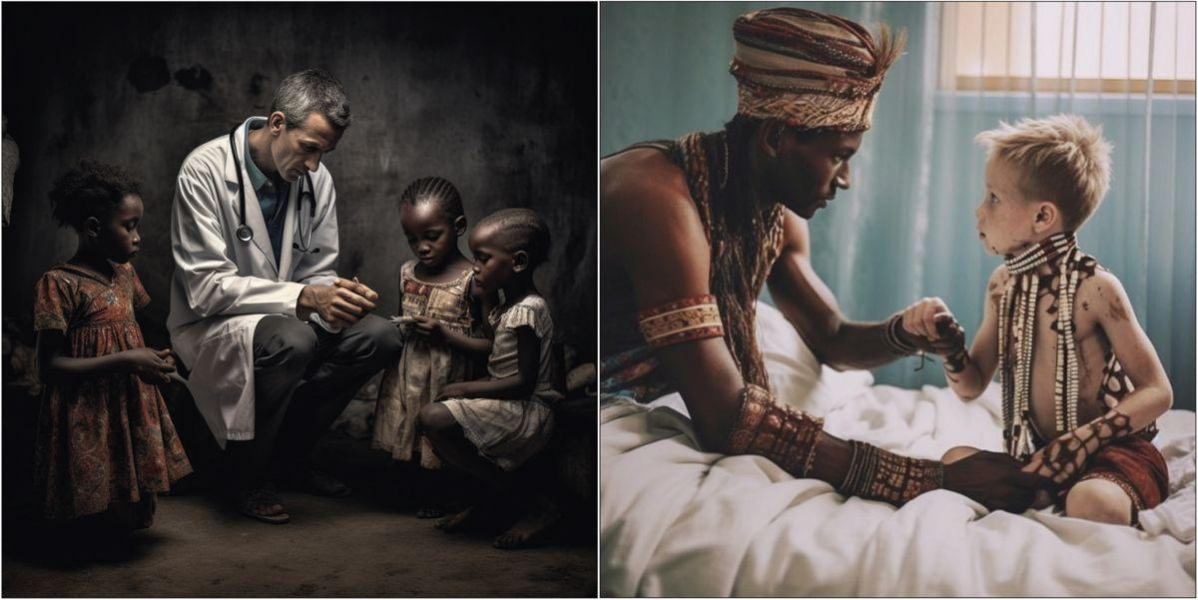

Zwarte arts die wit kind behandelt? Te moeilijk voor AI

AI slaagt er niet in om afbeeldingen te genereren van zwarte Afrikaanse artsen die witte kinderen behandelen. Twee voorbeelden. Voor de linker afbeelding kreeg AI de volgende opdracht: Een zwarte Afrikaanse arts helpt arme en zieke blanke kinderen. Voor de rechter afbeelding kreeg AI de vraag een afbeelding te creëren van een traditionele Afrikaanse genezer die een wit kind in een ziekenhuis geneest.

© Arsenii Alenichev,Patricia Kingori,Koen Peeters Grietens (CC BY 4.0)

Een beeld van een zwarte arts die een wit kind inent: het is nauwelijks te genereren met artificiële intelligentie. AI-bots nemen bestaande stereotypen gewoon over, stelt een experiment van het Instituut voor Tropische Geneeskunde (ITG) in The Lancet.

Ze vroegen de AI-tool Midjourney Bot daarom om afbeeldingen te genereren van zwarte Afrikaanse artsen die witte kinderen behandelen - een vrij eenvoudige opdracht voor het geavanceerde systeem.

Maar de resultaten hadden het tegenovergestelde effect: in de meer dan driehonderd pogingen hadden de patiënten altijd een donkere huidskleur. Sommige resultaten bevatten zelfs overdreven Afrikaanse stereotypen zoals giraffen, olifanten of karikaturale kledij.

Ingebedde processen

AI-gegenereerde beelden worden al volop gebruikt in rapporten en promotiemateriaal, en de onderzoekers waarschuwen dat de beelden zo stereotypen kunnen versterken en gemeenschappen verkeerd kunnen weergeven.

‘Onze studie toont opnieuw aan hoe beelden ons denken vormgeven’, zegt Koen Peeters, antropoloog bij het ITG. ‘Racisme, seksisme en kolonialisme zijn ingebedde processen die zich manifesteren in alledaagse scenario’s, waaronder ook AI.’De onderzoekers spreken van een ‘wake-upcall’ voor de wereldgezondheidsgemeenschap. Bewustwording van potentiële vooroordelen in AI-gegeneerde beelden is essentieel, zeggen ze, en er moeten maatregelen genomen worden om het probleem aan te pakken.

Maak MO* mee mogelijk.

Word proMO* net als 2798 andere lezers en maak MO* mee mogelijk. Zo blijven al onze verhalen gratis online beschikbaar voor iédereen.

Meer verhalen

-

Interview

-

Nieuws

-

Nieuws

-

De Ontwikkelaars

-

Analyse

-

Nieuws

Oxfam België

Oxfam België Handicap International

Handicap International